Биномиальное распределение - Binomial distribution

|

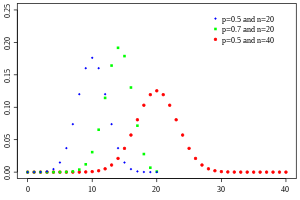

Вероятностная функция масс

| |||

|

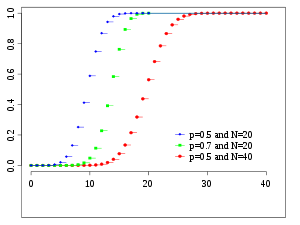

Кумулятивная функция распределения

| |||

| Обозначение | |||

|---|---|---|---|

| Параметры |

- количество испытаний - вероятность успеха для каждого испытания |

||

| Служба поддержки | - количество успехов | ||

| PMF | |||

| CDF | |||

| Иметь в виду | |||

| Медиана | или | ||

| Режим | или | ||

| Дисперсия | |||

| Асимметрия | |||

| Бывший. эксцесс | |||

| Энтропия |

в шаннонах . Для натсов используйте в журнале натуральный журнал. |

||

| MGF | |||

| CF | |||

| PGF | |||

| Информация Fisher |

(для фиксированного ) |

||

| Часть серии по статистике |

| Теория вероятности |

|---|

|

В теории вероятностей и статистике , в биномиальном распределении с параметрами п и р является дискретным распределением вероятностей числа успехов в последовательности п независимых опытов , каждый Задавая да-нет вопроса , и каждый со своим собственными булевым -значным результатом : успех (с вероятностью p ) или неудача (с вероятностью q = 1 - p ). Единичный эксперимент с успехом / неудачей также называется испытанием Бернулли или экспериментом Бернулли, а последовательность результатов называется процессом Бернулли ; для одного испытания, т. е. n = 1, биномиальное распределение является распределением Бернулли . Биномиальное распределение является основой для популярного биномиального теста на статистическую значимость .

Биномиальное распределение часто используется для моделирования числа успехов в выборке размера п обращается с заменой из популяции размера N . Если выборка выполняется без замены, розыгрыши не являются независимыми, и поэтому результирующее распределение является гипергеометрическим распределением , а не биномиальным. Однако для N, намного большего, чем n , биномиальное распределение остается хорошим приближением и широко используется.

Определения

Вероятностная функция масс

В общем случае, если случайная величина X подчиняется биномиальному распределению с параметрами n ∈ ℕ и p ∈ [0,1], мы пишем X ~ B ( n , p ). Вероятность получить ровно k успехов в n независимых испытаниях Бернулли определяется функцией массы вероятности :

для k = 0, 1, 2, ..., n , где

- биномиальный коэффициент , отсюда и название распределения. Формулу можно понять так: k успехов происходят с вероятностью p k и n - k неудач происходят с вероятностью (1 - p ) n - k . Однако k успешных результатов могут произойти где угодно среди n попыток, и существуют разные способы распределения k успехов в последовательности из n попыток.

При создании справочных таблиц для вероятностей биномиального распределения обычно таблица заполняется до n / 2 значений. Это связано с тем, что для k > n / 2 вероятность может быть вычислена путем его дополнения как

Если посмотреть на выражение f ( k , n , p ) как функцию от k , найдется значение k, которое максимизирует его. Это значение k можно найти, вычислив

и сравнивая его с 1. Всегда существует целое число M , удовлетворяющее

f ( k , n , p ) монотонно возрастает при k < M и монотонно убывает при k > M , за исключением случая, когда ( n + 1) p является целым числом. В этом случае есть два значения, для которых f является максимальным: ( n + 1) p и ( n + 1) p - 1. M является наиболее вероятным исходом (то есть наиболее вероятным, хотя это все еще может быть маловероятным. в целом) испытаний Бернулли и называется режимом .

Пример

Предположим, при подбрасывании искаженной монеты выпадает орел с вероятностью 0,3. Вероятность увидеть ровно 4 решки за 6 бросков равна

Кумулятивная функция распределения

Интегральная функция распределения может быть выражена как:

где "этаж" под k , то есть наибольшее целое число, меньшее или равное k .

Его также можно представить в терминах регуляризованной неполной бета-функции следующим образом:

которая эквивалентна кумулятивной функции распределения от F -распределения :

Некоторые оценки в закрытой форме для кумулятивной функции распределения приведены ниже .

Характеристики

Ожидаемая стоимость и отклонение

Если X ~ B ( п , р ), то есть, Х представляет собой биномиально распределенная случайная величина, п быть общее число экспериментов и р вероятность каждого эксперимента , получа положительный результат, то ожидаемое значение из X является:

Это следует из линейности ожидаемого значения и того факта, что X представляет собой сумму n идентичных случайных величин Бернулли, каждая из которых имеет ожидаемое значение p . Другими словами, если идентичны (и независимы) случайные величины Бернулли с параметром p , то и

Дисперсия является:

Это аналогично следует из того факта, что дисперсия суммы независимых случайных величин является суммой дисперсий.

Высшие моменты

Первые 6 центральных моментов , определяемые как , задаются формулой

Нецентральные моменты удовлетворяют

и вообще

где являются числами Стирлинга второго рода , а это го падения мощности из . Простая оценка следует из ограничения биномиальных моментов через высшие моменты Пуассона :

Это показывает, что если , то является не более чем постоянным множителем, отличным от

Режим

Обычно режим биномиального распределения B ( n , p ) равен , где - минимальная функция . Однако, когда ( n + 1) p является целым числом и p не равно ни 0, ни 1, тогда распределение имеет два режима: ( n + 1) p и ( n + 1) p - 1. Когда p равно 0 или 1 режим будет 0 и n соответственно. Эти случаи можно резюмировать следующим образом:

Доказательство: Пусть

Для только имеет значение отличное от нуля с . Ибо мы находим и для . Это доказывает, что режим равен 0 для и для .

Пусть . Мы нашли

- .

Из этого следует

Итак, когда - целое число, тогда и - это режим. В этом случае только режим.

Медиана

В общем, не существует единой формулы для нахождения медианы для биномиального распределения, и оно может даже быть неуникальным. Однако было установлено несколько особых результатов:

- Если np является целым числом, то среднее значение, медиана и мода совпадают и равны np .

- Любая медиана m должна лежать в интервале ⌊ np ⌋ ≤ m ≤ np ⌉.

- Медиана m не может находиться слишком далеко от среднего: | м - нп | ≤ min {ln 2, max { p , 1 - p } }.

- Медиана уникальна и равна m = round ( np ), когда | м - нп | ≤ min { p , 1 - p } (кроме случая, когда p = 1/2и n нечетное).

- Когда p - рациональное число (за исключением p = 1/2 и нечетного n ), медиана уникальна.

- Когда p = 1/2 и n нечетно, любое число m в интервале1/2( п - 1) ≤ м ≤ 1/2( n + 1) - медиана биномиального распределения. Если p = 1/2 и n четно, то m = n / 2 - единственная медиана.

Границы хвоста

Для k ≤ np верхние границы могут быть получены для нижнего хвоста кумулятивной функции распределения - вероятности того, что имеется не более k успешных результатов. Поскольку эти границы также можно рассматривать как границы верхнего хвоста кумулятивной функции распределения при k ≥ np .

Неравенство Хёффдинга дает простую оценку

что, однако, не очень плотно. В частности, для p = 1 мы имеем, что F ( k ; n , p ) = 0 (для фиксированного k , n с k < n ), но оценка Хёффдинга дает положительную константу.

Более точную оценку можно получить из оценки Чернова :

где D ( a || p ) - относительная энтропия (или расхождение Кульбака-Лейблера) между a -coin и p -coin (то есть между распределениями Бернулли ( a ) и Бернулли ( p )):

Асимптотически это ограничение достаточно жесткое; подробности см.

Можно также получить нижнюю границу хвоста , известную как границы антиконцентрации. Аппроксимируя биномиальный коэффициент формулой Стирлинга, можно показать, что

что влечет более простую, но более слабую оценку

Для p = 1/2 и k ≥ 3 n / 8 для четного n знаменатель можно сделать постоянным:

Связанные дистрибутивы

Суммы биномов

Если X ~ B ( n , p ) и Y ~ B ( m , p ) - независимые биномиальные переменные с одинаковой вероятностью p , то X + Y снова является биномиальной переменной; его распределение имеет вид Z = X + Y ~ B ( n + m , p ):

Биномиальная распределенная случайная величина X ~ B ( n , p ) может рассматриваться как сумма n случайных величин, распределенных по Бернулли. Таким образом, сумма двух биномиальных распределенных случайных величин X ~ B ( n , p ) и Y ~ B ( m , p ) эквивалентна сумме n + m случайных величин, распределенных Бернулли, что означает Z = X + Y ~ B ( п + м , п ). Это также можно доказать напрямую, используя правило сложения.

Однако, если X и Y не имеют одинаковой вероятности p , то дисперсия суммы будет меньше, чем дисперсия биномиальной переменной, распределенной как

Биномиальное распределение Пуассона

Биномиальное распределение - это частный случай биномиального распределения Пуассона или общего биномиального распределения , которое представляет собой распределение суммы n независимых неидентичных испытаний Бернулли B ( p i ).

Соотношение двух биномиальных распределений

Этот результат был впервые получен Кацем и соавторами в 1978 году.

Пусть X ~ B ( n , p 1 ) и Y ~ B ( m , p 2 ) независимы. Пусть T = ( X / n ) / ( Y / m ).

Тогда log ( T ) приблизительно нормально распределен со средним логарифмом ( p 1 / p 2 ) и дисперсией ((1 / p 1 ) - 1) / n + ((1 / p 2 ) - 1) / m .

Условные биномы

Если X ~ B ( n , p ) и Y | X ~ B ( X , q ) (условное распределение Y , заданное X ), тогда Y - простая биномиальная случайная величина с распределением Y ~ B ( n , pq ).

Например, представьте себе , бросая п шары в корзину U X и принимая шары, удар и бросать их в другую корзину U Y . Если р есть вероятность того , достиг U X , то Х \ В ( п , р ) является количеством шаров , которые поражают U X . Если q - это вероятность попасть в U Y, то количество шаров, попавших в U Y, равно Y ~ B ( X , q ) и, следовательно, Y ~ B ( n , pq ).

Так как и , по закону полной вероятности ,

Поскольку приведенное выше уравнение может быть выражено как

Факторинг и вытягивание всех сроков, которые не зависят от суммы, теперь дает

После подстановки в выражение выше получаем

Обратите внимание, что сумма (в скобках) выше равна по биномиальной теореме . Подставляя это в finally, дает

и таким образом по желанию.

Распределение Бернулли

Распределение Бернулли является частным случаем биномиального распределения, где n = 1. Символически X ~ B (1, p ) имеет то же значение, что и X ~ Bernoulli ( p ). И наоборот, любое биномиальное распределение B ( n , p ) является распределением суммы n независимых испытаний Бернулли, Bernoulli ( p ), каждое с одинаковой вероятностью p .

Нормальное приближение

Если n достаточно велико, то перекос распределения не слишком велик. В этом случае разумное приближение к B ( n , p ) дается нормальным распределением

и это базовое приближение можно просто улучшить, используя подходящую поправку на непрерывность . Базовое приближение обычно улучшается при увеличении n (по крайней мере на 20) и лучше, когда p не близко к 0 или 1. Можно использовать различные эмпирические правила, чтобы решить, достаточно ли n , а p достаточно далеко от крайних значений. ноль или один:

- Одно правило состоит в том, что для n > 5 нормальное приближение является адекватным, если абсолютное значение асимметрии строго меньше 1/3; то есть, если

Это можно уточнить с помощью теоремы Берри – Эссеена .

- Более сильное правило гласит, что нормальное приближение подходит только в том случае, если все в пределах 3 стандартных отклонений от его среднего находится в пределах диапазона возможных значений; то есть, только если

- Это правило трех стандартных отклонений эквивалентно следующим условиям, которые также подразумевают первое правило выше.

Правило полностью эквивалентно требованию, чтобы

Перемещение терминов вокруг урожайности:

Поскольку мы можем применить квадрат мощности и разделить на соответствующие множители и , чтобы получить желаемые условия:

Обратите внимание, что эти условия автоматически подразумевают это . С другой стороны, снова примените квадратный корень и разделите на 3,

Вычитание второго набора неравенств из первого дает:

Итак, желаемое первое правило выполнено,

- Другое часто используемое правило состоит в том, что оба значения и должны быть больше или равны 5. Однако конкретное число варьируется от источника к источнику и зависит от того, насколько хорошее приближение требуется. В частности, если использовать 9 вместо 5, правило подразумевает результаты, указанные в предыдущих параграфах.

Предположим, что оба значения и больше 9. Поскольку мы легко получаем, что

Теперь нам нужно только разделить на соответствующие множители и , чтобы вывести альтернативную форму правила трех стандартных отклонений:

Ниже приведен пример применения коррекции непрерывности . Предположим , что кто -то желает вычислить Pr ( X ≤ 8) для бином случайная величина Х . Если Y имеет распределение, заданное нормальным приближением, то Pr ( X ≤ 8) аппроксимируется Pr ( Y ≤ 8.5). Добавление 0,5 - это поправка на непрерывность; неисправленное нормальное приближение дает значительно менее точные результаты.

Это приближение, известное как теорема де Муавра – Лапласа , значительно экономит время при выполнении вычислений вручную (точные вычисления с большим n очень обременительны); исторически это было первое использование нормального распределения, введенное в книге Абрахама де Муавра « Доктрина шансов» в 1738 году. В настоящее время его можно рассматривать как следствие центральной предельной теоремы, поскольку B ( n , p ) является сумма n независимых, одинаково распределенных переменных Бернулли с параметром p . Этот факт является основой проверки гипотезы , «z-критерия пропорции», для значения p с использованием x / n , доли выборки и оценки p в общей статистике теста .

Например, предположим, что кто-то произвольно выбирает n человек из большой совокупности и спрашивает их, согласны ли они с определенным утверждением. Доля согласных, конечно, будет зависеть от выборки. Если бы группы из n человек отбирались повторно и действительно случайным образом, пропорции следовали бы приблизительному нормальному распределению со средним значением, равным истинной пропорции p согласия в совокупности, и со стандартным отклонением.

Пуассоновское приближение

Биномиальное распределение сходится к распределению Пуассона, когда количество попыток стремится к бесконечности, в то время как произведение np остается фиксированным или, по крайней мере, p стремится к нулю. Следовательно, распределение Пуассона с параметром λ = np можно использовать в качестве приближения к B ( n , p ) биномиального распределения, если n достаточно велико, а p достаточно мало. Согласно двум практическим правилам, это приближение хорошо, если n ≥ 20 и p ≤ 0,05, или если n ≥ 100 и np ≤ 10.

Относительно точности пуассоновского приближения см. Новак, гл. 4 и ссылки в нем.

Ограничение раздач

- Предельная теорема Пуассона : когда n приближается к ∞, а p приближается к 0 прификсированномпроизведении np , биномиальное ( n , p ) распределение приближается к распределению Пуассона с математическим ожиданием λ = np .

- Теорема де Муавра – Лапласа : когда n приближается к ∞, а p остается фиксированным, распределение

- приближается к нормальному распределению с ожидаемым значением 0 и дисперсией 1. Этот результат иногда свободно формулируют, говоря, что распределение X является асимптотически нормальным с ожидаемым значением np и дисперсией np (1 - p ). Этот результат является частным случаем центральной предельной теоремы .

Бета-распределение

Биномиальное распределение и бета-распределение - это разные взгляды на одну и ту же модель повторных испытаний Бернулли. Биномиальное распределение является PMF из K успехов заданных п независимых событий каждого с вероятностью р успеха. Математически, когда α = k + 1 и β = n - k + 1 , бета-распределение и биномиальное распределение связаны коэффициентом n + 1 :

Бета-распределения также предоставляют семейство априорных распределений вероятностей для биномиальных распределений в байесовском выводе :

При равномерном априорном распределении апостериорное распределение вероятности успеха p при n независимых событиях с k наблюдаемыми успехами является бета-распределением.

Статистические выводы

Оценка параметров

Когда n известно, параметр p может быть оценен с использованием доли успехов: эта оценка находится с использованием оценки максимального правдоподобия, а также метода моментов . Эта оценка является несмещенной и равномерно с минимальной дисперсией , что доказано с помощью теоремы Лемана – Шеффе , поскольку она основана на минимальной достаточной и полной статистике (например, x ). Это также согласуется как по вероятности, так и по MSE .

Байесовская оценка в закрытой форме для p также существует при использовании бета-распределения в качестве сопряженного априорного распределения . При использовании общего , как до, то задняя средняя оценка является: . Байесовская оценка асимптотически эффективна, и по мере приближения размера выборки к бесконечности ( n → ∞) она приближается к решению MLE . Оценка Байеса смещена (насколько зависит от априорных значений), допустима и непротиворечива по вероятности.

Для особого случая использования стандартного равномерного распределения в качестве неинформативного априорного ( ) апостериорная средняя оценка становится ( апостериорная мода должна просто вести к стандартной оценке). Этот метод называется правилом преемственности , которое было введено в 18 веке Пьером-Симоном Лапласом .

При оценке p с очень редкими событиями и малым n (например: если x = 0) использование стандартной оценки приводит к тому, что иногда нереально и нежелательно. В таких случаях существуют различные альтернативные оценки. Один из способов - использовать байесовскую оценку, что приведет к:) . Другой способ заключается в использовании верхней границы доверительного интервала , полученном с использованием правила трех : )

Доверительные интервалы

Даже для довольно больших значений n фактическое распределение среднего существенно ненормально. Из-за этой проблемы было предложено несколько методов оценки доверительных интервалов.

В приведенных ниже уравнениях для доверительных интервалов переменные имеют следующее значение:

- n 1 - количество успехов из n , общее количество попыток

- доля успехов

- это квантиль из стандартного нормального распределения (т.е. пробит ) , соответствующей целевой частоты появления ошибок . Например, для уровня достоверности 95% ошибка = 0,05, поэтому = 0,975 и = 1,96.

Метод Вальда

- Коррекции непрерывности 0,5 / п могут быть добавлены.

Метод Агрести – Коулла

- Здесь оценка p изменена на

- Этот метод подходит для и . См. Здесь . Для использования метода Уилсона (оценка) ниже.

Арксинус метод

Метод Вильсона (оценка)

Обозначения в приведенной ниже формуле отличаются от предыдущих формул в двух отношениях:

- Во-первых, z x имеет несколько иную интерпретацию в приведенной ниже формуле: он имеет свое обычное значение « x- й квантиль стандартного нормального распределения», а не является сокращением для «(1 - x ) -го квантиля».

- Во-вторых, в этой формуле не используется знак «плюс-минус» для определения двух границ. Вместо этого можно использовать для получения нижней границы или использовать для получения верхней границы. Например: для уровня достоверности 95% ошибка = 0,05, поэтому нижнюю границу можно получить с помощью , а верхнюю - с помощью .

Сравнение

Точный метод ( Клоппера – Пирсона ) является наиболее консервативным.

Метод Вальда, хотя его часто рекомендуют в учебниках, является наиболее предвзятым.

Вычислительные методы

Генерация биномиальных случайных величин

Методы генерации случайных чисел, в которых маргинальное распределение является биномиальным распределением, хорошо известны.

Один из способов генерировать случайные выборки из биномиального распределения - использовать алгоритм инверсии. Для этого необходимо вычислить вероятность того, что Pr ( X = k ) для всех значений k от 0 до n . (Эти вероятности должны быть суммированы до значения, близкого к единице, чтобы охватить все пространство выборки.) Затем, используя генератор псевдослучайных чисел для генерации выборок равномерно между 0 и 1, можно преобразовать вычисленные выборки в дискретные числа с помощью вероятности, рассчитанные на первом этапе.

История

Это распределение было получено Якобом Бернулли . Он рассмотрел случай, когда p = r / ( r + s ), где p - вероятность успеха, а r и s - положительные целые числа. Блез Паскаль ранее рассматривал случай, когда p = 1/2.

Смотрите также

- Логистическая регрессия

- Полиномиальное распределение

- Отрицательное биномиальное распределение

- Бета-биномиальное распределение

- Биномиальная мера, пример мультифрактальной меры .

- Статистическая механика

- Лемма о накоплении , результирующая вероятность, когда XOR -ing независимые булевы переменные

использованная литература

дальнейшее чтение

- Хирш, Вернер З. (1957). «Биномиальное распределение - успех или неудача, насколько они вероятны?» . Введение в современную статистику . Нью-Йорк: Макмиллан. С. 140–153.

- Нетер, Джон; Вассерман, Уильям; Уитмор, Джорджия (1988). Прикладная статистика (Третье изд.). Бостон: Аллин и Бэкон. С. 185–192. ISBN 0-205-10328-6.

внешние ссылки

- Интерактивная графика: одномерные отношения распределения

- Калькулятор формулы биномиального распределения

- Разница двух биномиальных переменных: XY или | XY |

- Запрос биномиального распределения вероятностей в WolframAlpha

![{\ displaystyle p \ in [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/33c3a52aa7b2d00227e85c641cca67e85583c43c)

![{\ displaystyle G (z) = [q + pz] ^ {n}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/40494c697ce2f88ebb396ac0191946285cadcbdd)

![{\ displaystyle \ operatorname {E} [X] = np.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3f16b365410a1b23b5592c53d3ae6354f1a79aff)

![{\ displaystyle \ operatorname {E} [X] = \ operatorname {E} [X_ {1} + \ cdots + X_ {n}] = \ operatorname {E} [X_ {1}] + \ cdots + \ operatorname { E} [X_ {n}] = p + \ cdots + p = np.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5f238d520c68a1d1b9b318492ddda39f4cc45bb8)

![{\ displaystyle \ mu _ {c} = \ operatorname {E} \ left [(X- \ operatorname {E} [X]) ^ {c} \ right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/1c5ea3e05b674668550675c3c4593c725a1ec86b)

![{\ displaystyle {\ begin {align} \ operatorname {E} [X] & = np, \\\ operatorname {E} [X ^ {2}] & = np (1-p) + n ^ {2} p ^ {2}, \ end {выровнено}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b3f2b3a9af52fc1ea633476400290069fc3ae7b4)

![{\ displaystyle \ operatorname {E} [X ^ {c}] = \ sum _ {k = 0} ^ {c} \ left \ {{c \ atop k} \ right \} n ^ {\ underline {k} } p ^ {k},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/db435ced7af59fa481fe26a023a1429d18a6a83a)

![{\ displaystyle \ operatorname {E} [X ^ {c}] \ leq \ left ({\ frac {c} {\ log (c / (np) +1)}} \ right) ^ {c} \ leq ( np) ^ {c} \ exp \ left ({\ frac {c ^ {2}} {2np}} \ right).}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e6b86926254189719acfa57fcc1650caf698c292)

![{\ displaystyle \ operatorname {E} [X ^ {c}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5989f9c9f5202059ad1c0a4026d267ee2a975761)

![{\ Displaystyle \ OperatorName {E} [X] ^ {c}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/74d46bd564a6f77db38e12b156443bdbc3262cfb)

![{\ begin {align} \ operatorname {P} (Z = k) & = \ sum _ {i = 0} ^ {k} \ left [{\ binom {n} {i}} p ^ {i} (1 -p) ^ {ni} \ right] \ left [{\ binom {m} {ki}} p ^ {ki} (1-p) ^ {m-k + i} \ right] \\ & = {\ binom {n + m} {k}} p ^ {k} (1-p) ^ {n + mk} \ end {выровнено}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/38fc38e9a5e2c49743f45b4dab5dae6230ab2ad5)

![{\ Displaystyle {\ begin {align} \ Pr [Y = m] & = \ sum _ {k = m} ^ {n} \ Pr [Y = m \ mid X = k] \ Pr [X = k] \ \ [2pt] & = \ sum _ {k = m} ^ {n} {\ binom {n} {k}} {\ binom {k} {m}} p ^ {k} q ^ {m} (1 -p) ^ {нк} (1-д) ^ {км} \ конец {выровнено}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/7e8f896e04f3bc2c13d2eed61e48bd43e63f6406)

![{\ displaystyle \ Pr [Y = m] = \ sum _ {k = m} ^ {n} {\ binom {n} {m}} {\ binom {nm} {km}} p ^ {k} q ^ {m} (1-p) ^ {nk} (1-q) ^ {km}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8369ef846ffda72900efc67b334923f70ce48ca5)

![{\ displaystyle {\ begin {align} \ Pr [Y = m] & = {\ binom {n} {m}} p ^ {m} q ^ {m} \ left (\ sum _ {k = m} ^ {n} {\ binom {nm} {km}} p ^ {km} (1-p) ^ {nk} (1-q) ^ {km} \ right) \\ [2pt] & = {\ binom { n} {m}} (pq) ^ {m} \ left (\ sum _ {k = m} ^ {n} {\ binom {nm} {km}} \ left (p (1-q) \ right) ^ {km} (1-p) ^ {nk} \ right) \ end {выровнено}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/caaa36dbcb3b4c43d7d5310533ef9d4809ba9db8)

![{\ displaystyle \ Pr [Y = m] = {\ binom {n} {m}} (pq) ^ {m} \ left (\ sum _ {i = 0} ^ {nm} {\ binom {nm} { i}} (p-pq) ^ {i} (1-p) ^ {nmi} \ right)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/54401b2dd0936ca0904832912df2fe9b2c3d5153)

![{\ displaystyle {\ begin {align} \ Pr [Y = m] & = {\ binom {n} {m}} (pq) ^ {m} (p-pq + 1-p) ^ {nm} \\ [4pt] & = {\ binom {n} {m}} (pq) ^ {m} (1-pq) ^ {nm} \ end {align}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/324b106ed5f362da979eebfc0feaa94b44b713b2)