Философия искусственного интеллекта - Philosophy of artificial intelligence

| Часть серии о |

| Искусственный интеллект |

|---|

Философии искусственного интеллекта является ветвью философии техники , которая исследует искусственный интеллект и его последствия для познания и понимания интеллекта , этики , сознания , гносеологии и свободной воли . Кроме того, технология связана с созданием искусственных животных или искусственных людей (или, по крайней мере, искусственных существ; см. Искусственную жизнь ), поэтому эта дисциплина представляет значительный интерес для философов. Эти факторы способствовали возникновению философии искусственного интеллекта . Некоторые ученые утверждают, что игнорирование философии сообществом ИИ пагубно.

Философия искусственного интеллекта пытается ответить на такие вопросы следующим образом:

- Может ли машина действовать разумно? Может ли он решить любую проблему, которую человек решил бы, думая?

- Человеческий интеллект и машинный интеллект - это одно и то же? По сути, человеческий мозг - это компьютер?

- Может ли машина иметь разум , ментальные состояния и сознание в том же смысле, что и человек? Можно ли чувствовать себя , как обстоит дело ?

Подобные вопросы отражают различные интересы исследователей ИИ , ученых-когнитивистов и философов соответственно. Научные ответы на эти вопросы зависят от определения понятий «интеллект» и «сознание» и от того, какие именно «машины» обсуждаются.

Важные положения философии ИИ включают некоторые из следующих:

- «Вежливое соглашение» Тьюринга : если машина ведет себя так же разумно, как человек, то она так же разумна, как и человек.

- Предложение Дартмута : «Каждый аспект обучения или любая другая особенность интеллекта может быть описана настолько точно, что можно создать машину для его моделирования».

- Аллен Ньюэлл и Герберт А. Саймон «s физическая система символов гипотеза:„Физическая символическая система имеет необходимые и достаточные средства общего интеллектуального действия.“

- Джон Серл «s сильная гипотеза AI :„соответствующим образом запрограммировать компьютер с нужными входами и выходами будет , таким образом , иметь ум в точно такой же смысл у людей есть разум.“

- Механизм Гоббса : «Потому что« разум »... есть не что иное, как« расчет », то есть сложение и вычитание последствий общих названий, согласованных для« маркировки »и« обозначения »наших мыслей ...»

Может ли машина показать общий интеллект?

Возможно ли создать машину, которая сможет решить все проблемы, которые люди решают с помощью своего интеллекта? Этот вопрос определяет объем того, что машины могут делать в будущем, и определяет направление исследований ИИ. Он касается только поведения машин и игнорирует вопросы, интересующие психологов , ученых-когнитивистов и философов ; чтобы ответить на этот вопрос, не имеет значения , является ли машина действительно думает (как думает человек) или просто действует как это мышление.

Основная позиция большинства исследователей искусственного интеллекта резюмируется в этом заявлении, которое появилось в предложении для семинара в Дартмуте 1956 года:

- «Каждый аспект обучения или любая другая особенность интеллекта может быть описана с такой точностью, что можно создать машину для его моделирования».

Аргументы против основной посылки должны показать, что создание работающей системы ИИ невозможно, потому что есть некоторый практический предел возможностей компьютеров или что есть какое-то особое качество человеческого разума, которое необходимо для разумного поведения и которое, тем не менее, не может быть воспроизведено каким-либо человеком. машина (или методами текущего исследования ИИ). Аргументы в пользу основной посылки должны показать, что такая система возможна.

Также можно обойти связь между двумя частями вышеуказанного предложения. Например, машинное обучение, начавшееся с печально известного предложения Тьюринга о дочерних машинах, по сути, обеспечивает желаемую интеллектуальную способность без точного описания во время разработки того, как именно это будет работать. Учет неявных знаний роботов устраняет необходимость в точном описании.

Первый шаг к ответу на вопрос - дать четкое определение «интеллекта».

Интеллект

Тест Тьюринга

Алан Тьюринг свел проблему определения интеллекта к простому вопросу о разговоре. Он предполагает, что: если машина может ответить на любой заданный ей вопрос, используя те же слова, что и обычный человек, то мы можем назвать эту машину интеллектуальной. Современная версия его экспериментального проекта будет использовать онлайн- чат , где один из участников - реальный человек, а один из участников - компьютерная программа. Программа проходит проверку, если никто не может сказать, кто из двух участников - человек. Тьюринг отмечает, что никто (кроме философов) никогда не задает вопрос «могут ли люди думать?» Он пишет: «Вместо того, чтобы постоянно спорить по этому поводу, обычно принято вежливое соглашение, о котором думают все». Тест Тьюринга распространяет это вежливое соглашение на машины:

- Если машина действует так же разумно, как человек, то она так же разумна, как и человек.

Одна из критических замечаний по поводу теста Тьюринга состоит в том, что он измеряет только «человечность» поведения машины, а не «интеллект» поведения. Поскольку человеческое поведение и разумное поведение - не одно и то же, тест не может измерить интеллект. Стюарт Дж. Рассел и Питер Норвиг пишут, что «тексты по авиационной инженерии не определяют цель своей области как« создание машин, которые летают так точно, как голуби, что они могут обмануть других голубей ».

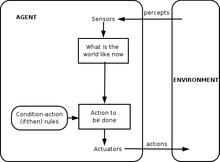

Определение интеллектуального агента

Исследования ИИ XXI века определяют интеллект в терминах интеллектуальных агентов . «Агент» - это то, что воспринимает окружающую среду и действует в ней. «Показатель производительности» определяет, что считается успехом для агента.

- «Если агент действует так, чтобы максимизировать ожидаемое значение показателя производительности, основанного на прошлом опыте и знаниях, тогда он умный».

Подобные определения пытаются уловить сущность интеллекта. У них есть то преимущество, что, в отличие от теста Тьюринга, они также не проверяют неразумные человеческие черты, такие как опечатки или способность быть оскорбленными. У них есть недостаток, заключающийся в том, что они не умеют различать «вещи, которые думают» и «вещи, которые не умеют». Согласно этому определению, даже термостат имеет элементарный интеллект.

Аргументы в пользу того, что машина может демонстрировать общий интеллект

Мозг можно смоделировать

Хьюберт Дрейфус описывает этот аргумент как утверждение, что «если нервная система подчиняется законам физики и химии, а у нас есть все основания предполагать, что она подчиняется, то ... мы ... должны быть в состоянии воспроизвести поведение нервной системы. нервная система с каким-то физическим устройством ». Этот аргумент, впервые представленный еще в 1943 году и ярко описанный Гансом Моравеком в 1988 году, теперь ассоциируется с футуристом Рэем Курцвейлом , который считает, что мощности компьютера будет достаточно для полного моделирования мозга к году. 2029. Моделирование таламокортикальной модели, которая имеет размер человеческого мозга ( 10-11 нейронов), не в реальном времени, было выполнено в 2005 году, и потребовалось 50 дней, чтобы смоделировать 1 секунду динамики мозга на кластере из 27 процессоров.

Даже самые суровые критики ИИ (такие как Хьюберт Дрейфус и Джон Сёрл ) соглашаются с тем, что моделирование мозга теоретически возможно. Однако Сирл указывает, что в принципе все может быть смоделировано компьютером; таким образом, доведение определения до критической точки приводит к выводу, что любой процесс вообще может технически считаться «вычислением». «Мы хотели знать, что отличает разум от термостатов и печени», - пишет он. Таким образом, простое моделирование функционирования живого мозга само по себе было бы признанием незнания интеллекта и природы разума, как попытка построить реактивный авиалайнер, точно копируя живую птицу, перо за пером, без теоретического понимания авиационная техника .

Человеческое мышление - это обработка символов

В 1963 году Аллен Ньюэлл и Герберт А. Саймон предположили, что «манипулирование символами» является сутью как человеческого, так и машинного интеллекта. Они написали:

- «Система физических символов обладает необходимыми и достаточными средствами общего разумного действия».

Это утверждение очень сильное: оно подразумевает, что человеческое мышление является разновидностью манипулирования символами (поскольку система символов необходима для интеллекта) и что машины могут быть разумными (поскольку системы символов достаточно для интеллекта). Другой вариант этой позиции был описан философом Хьюбертом Дрейфусом, который назвал ее «психологическим допущением»:

- «Разум можно рассматривать как устройство, оперирующее битами информации в соответствии с формальными правилами».

«Символы», которые обсуждали Ньюэлл, Саймон и Дрейфус, были словесными и высокоуровневыми - символами, которые напрямую соотносятся с объектами в мире, такими как <собака> и <хвост>. В большинстве программ ИИ, написанных между 1956 и 1990 годами, использовались такие символы. Современный ИИ, основанный на статистике и математической оптимизации, не использует высокоуровневую «обработку символов», о которой говорили Ньюэлл и Саймон.

Аргументы против обработки символов

Эти аргументы показывают, что человеческое мышление не состоит (исключительно) из высокоуровневых манипуляций с символами. Они не показывают, что искусственный интеллект невозможен, только то, что требуется нечто большее, чем обработка символов.

Гёделевские антимеханистские аргументы

В 1931 году Курт Гёдель доказал с помощью теоремы о неполноте, что всегда можно построить « утверждение Гёделя », которое данная непротиворечивая формальная система логики (например, высокоуровневая программа манипулирования символами) не может доказать. Несмотря на то, что это истинное утверждение, построенное утверждение Гёделя недоказуемо в данной системе. (Истинность сконструированного утверждения Гёделя зависит от согласованности данной системы; применение того же процесса к слегка несовместимой системе будет казаться успешным, но на самом деле вместо этого приведет к ложному «утверждению Гёделя».) Более умозрительно, предположил Гёдель. что человеческий разум может в конечном итоге правильно определить истинность или ложность любого хорошо обоснованного математического утверждения (включая любое возможное утверждение Гёделя), и что, следовательно, сила человеческого разума не сводится к механизму . Философ Джон Лукас (с 1961 г.) и Роджер Пенроуз (с 1989 г.) отстаивали этот философский антимеханистский аргумент.

Геделианские антимеханистские аргументы имеют тенденцию полагаться на кажущееся безобидным утверждение о том, что система математиков-людей (или некоторая идеализация математиков-людей) одновременно последовательна (полностью свободна от ошибок) и полностью верит в свою собственную непротиворечивость (и может сделать все логичными). выводы, которые следуют из его собственной последовательности, включая веру в его утверждение Гёделя). Это, очевидно, невозможно для машины Тьюринга (см. Проблема остановки ); следовательно, гёделианец заключает, что человеческое мышление слишком мощно, чтобы его могла уловить машина Тьюринга и, в более широком смысле, любое цифровое механическое устройство.

Однако современное мнение в научном и математическом сообществе состоит в том, что реальные человеческие рассуждения непоследовательны; что любая последовательная «идеализированная версия» H человеческого рассуждения будет логически вынуждена принять здоровый, но противоречащий интуиции непредубежденный скептицизм по поводу непротиворечивости H (в противном случае H доказуемо несовместимо); и что теоремы Гёделя не приводят ни к какому действительному аргументу о том, что люди обладают способностями к математическому мышлению, превосходящими то, что машина могла бы когда-либо воспроизвести. Этот консенсус о том, что антимеханистские аргументы Гёделя обречены на провал, четко сформулирован в искусственном интеллекте : « любая попытка использовать (результаты неполноты Гёделя) для атаки на тезис вычислителя неизбежно будет незаконной, поскольку эти результаты вполне согласуются с выводами вычислителя. Тезис."

Стюарт Рассел и Питер Норвиг соглашаются, что аргумент Гёделя не учитывает природу реальных человеческих рассуждений. Это применимо к тому, что может быть доказано теоретически, учитывая бесконечное количество памяти и времени. На практике реальные машины (включая людей) имеют ограниченные ресурсы, и им будет сложно доказать многие теоремы. Необязательно уметь все доказывать, чтобы быть умным человеком.

Менее формально, Хофштадтер в его Пулитцеровской премии победы книги Гедель, Эшер, Бах: An Eternal Golden Braid , говорится , что это «Гедель-заявление» всегда относится к самой системе, проводя аналогию с тем , как Эпименид парадокса виды использования заявлением, ссылаются на себя, например, «это утверждение ложно» или «я лгу». Но, конечно, парадокс Эпименида применим ко всему, что делает заявления, будь то машины или люди, даже к самому Лукасу. Рассмотреть возможность:

- Лукас не может подтвердить истинность этого утверждения.

Это утверждение верно, но Лукас не может его утверждать. Это показывает, что сам Лукас подвержен тем же ограничениям, которые он описывает для машин, как и все люди, и поэтому аргумент Лукаса бессмыслен.

Сделав вывод о том, что человеческое мышление невозможно вычислить, Пенроуз продолжил спорную гипотезу о том, что некоторые гипотетические невычислимые процессы, включающие коллапс квантово-механических состояний, дают людям особое преимущество перед существующими компьютерами. Существующие квантовые компьютеры способны только снизить сложность вычислимых по Тьюрингу задач и по-прежнему ограничены задачами в рамках машин Тьюринга. По аргументам Пенроуза и Лукаса существующих квантовых компьютеров недостаточно, поэтому Пенроуз ищет какой-то другой процесс, включающий новые физика, например квантовая гравитация, которая могла бы проявить новую физику в масштабе массы Планка через спонтанный квантовый коллапс волновой функции. Он предположил, что эти состояния возникают как внутри нейронов, так и охватывают более одного нейрона. Однако другие ученые отмечают, что в мозгу нет правдоподобного органического механизма для использования каких-либо квантовых вычислений, и, кроме того, временная шкала квантовой декогеренции кажется слишком быстрой, чтобы влиять на срабатывание нейронов.

Дрейфус: примат неявных навыков

Хьюберт Дрейфус утверждал, что человеческий интеллект и опыт зависят в первую очередь от неявных навыков, а не явных символических манипуляций, и утверждал, что эти навыки никогда не будут отражены в формальных правилах.

Аргумент Дрейфуса предвосхитил Тьюринг в его статье 1950 года « Вычислительные машины и интеллект» , где он классифицировал это как «аргумент, основанный на неформальности поведения». В ответ Тьюринг утверждал, что то, что мы не знаем правил, управляющих сложным поведением, не означает, что таких правил не существует. Он писал: «мы не можем так легко убедить себя в отсутствии полных законов поведения ... достаточно искали. Таких законов нет ».

Рассел и Норвиг отмечают, что за годы, прошедшие с тех пор, как Дрейфус опубликовал свою критику, был достигнут прогресс в открытии «правил», управляющих бессознательными рассуждениями. Расположен движение в области робототехники исследований попытки захватить наши бессознательные навыки в восприятии и внимании. Парадигмы вычислительного интеллекта , такие как нейронные сети , эволюционные алгоритмы и т. Д., В основном направлены на моделирование бессознательного мышления и обучения. Статистические подходы к ИИ могут делать прогнозы, приближающиеся к точности интуитивных предположений человека. Исследования здравого смысла были сосредоточены на воспроизведении «фона» или контекста знания. Фактически, исследования ИИ в целом отошли от манипулирования символами высокого уровня к новым моделям, которые предназначены для большей части наших бессознательных рассуждений. Историк и исследователь искусственного интеллекта Даниэль Кревье писал, что «время доказало точность и восприимчивость некоторых комментариев Дрейфуса. Если бы он сформулировал их менее агрессивно, конструктивные действия, которые они предлагали, могли быть предприняты гораздо раньше».

Может ли машина иметь разум, сознание и психические состояния?

Это философский вопрос, связанный с проблемой других умов и трудной проблемой сознания . Вопрос вращается вокруг позиции, определенной Джоном Сирлом как «сильный ИИ»:

- Система физических символов может иметь ум и ментальные состояния.

Сирл отличал эту позицию от того, что он называл «слабым ИИ»:

- Система физических символов может действовать разумно.

Сирл ввел термины для отделения сильного ИИ от слабого, чтобы он мог сосредоточиться на том, что, по его мнению, было более интересным и спорным вопросом. Он утверждал, что даже если мы предположим, что у нас есть компьютерная программа, которая действует точно так же, как человеческий разум, все равно останется сложный философский вопрос, на который необходимо ответить.

Ни одна из двух позиций Серла не имеет большого значения для исследований ИИ, поскольку они не дают прямого ответа на вопрос «может ли машина проявлять общий интеллект?» (если также нельзя показать, что сознание необходимо для интеллекта). Тьюринг писал: «Я не хочу создавать впечатление, будто я думаю, что в сознании нет никакой тайны… [b] но я не думаю, что эти тайны обязательно нужно разгадывать, прежде чем мы сможем ответить на вопрос [могут ли машины думать]. " Рассел и Норвиг соглашаются: «Большинство исследователей ИИ принимают гипотезу слабого ИИ как должное и не заботятся о сильной гипотезе ИИ».

Есть несколько исследователей, которые считают, что сознание является важным элементом интеллекта, например Игорь Александер , Стэн Франклин , Рон Сан и Пентти Хайконен , хотя их определение «сознания» очень близко к «разуму». (См. Искусственное сознание .)

Прежде чем мы сможем ответить на этот вопрос, мы должны четко понимать, что мы подразумеваем под «умами», «ментальными состояниями» и «сознанием».

Сознание, умы, психические состояния, значение

Слова « разум » и « сознание » используются разными сообществами по-разному. Некоторые мыслители нового века , например, используют слово «сознание» для описания чего-то похожего на « élan vital » Бергсона : невидимый энергетический флюид, пронизывающий жизнь и особенно разум. Фантасты авторы используют слово , чтобы описать некоторые существенное свойство , которое делает нас человеком: машина или иностранец , который является «сознательным» будет представлен как полностью человеческий характер, с интеллектом, желаниями, будет , понимание, гордость и так далее. (Писатели-фантасты также используют слова «разумность», «разум», «самосознание» или « призрак » - как в манге и аниме « Призрак в доспехах » - для описания этого важного человеческого свойства). Для других слова «разум» или «сознание» используются как своего рода светский синоним души .

Для философов , нейробиологов и когнитивистов эти слова используются более точным и приземленным образом: они относятся к знакомому повседневному опыту наличия «мысли в голове», такой как восприятие, сон, намерение или план, и то, как мы что-то видим, что-то знаем, что-то значим или понимаем . «Нетрудно дать здравое определение сознания», - замечает философ Джон Сирл. То, что загадочно и увлекательно, заключается не столько в том, что это такое, сколько в том, как оно есть: как кусок жировой ткани и электричества дает начало этому (знакомому) опыту восприятия, смысла или мышления?

Философы называют это трудной проблемой сознания . Это последняя версия классической проблемы философии разума, которая называется « проблема разума и тела ». Смежная проблема - это проблема значения или понимания (которую философы называют « интенциональностью »): какова связь между нашими мыслями и тем, о чем мы думаем (то есть объектами и ситуациями в мире)? Третий вопрос - это проблема опыта (или « феноменологии »): если два человека видят одно и то же, имеют ли они одинаковый опыт? Или есть вещи «внутри их головы» (называемые « квалиа »), которые могут отличаться от человека к человеку?

Нейробиологи полагают, что все эти проблемы будут решены, когда мы начнем определять нейронные корреляты сознания : действительные отношения между механизмами в наших головах и их коллективными свойствами; такие как ум, опыт и понимание. Некоторые из самых резких критиков искусственного интеллекта соглашаются с тем, что мозг - это просто машина, а сознание и интеллект являются результатом физических процессов в мозге. Сложный философский вопрос заключается в следующем: может ли компьютерная программа, работающая на цифровой машине, которая перемешивает двоичные цифры нуля и единицы, дублировать способность нейронов создавать сознание с ментальными состояниями (такими как понимание или восприятие) и, в конечном итоге, опыт сознания ?

Аргументы о том, что компьютер не может иметь разум и психические состояния

Китайская комната Сирла

Джон Сирл просит нас рассмотреть мысленный эксперимент : предположим, мы написали компьютерную программу, которая проходит тест Тьюринга и демонстрирует разумное действие в целом. Предположим, конкретно, что программа может свободно разговаривать на китайском языке. Напишите программу на карточках 3х5 и отдайте их обычному человеку, не владеющему китайским языком. Заприте человека в комнате и попросите его следовать инструкциям на карточках. Он будет копировать китайские иероглифы и передавать их в комнату и выходить через прорезь. Со стороны может показаться, что в китайской комнате находится полностью умный человек, говорящий по-китайски. Вопрос в следующем: есть ли в комнате кто-нибудь (или что-нибудь), кто понимает по-китайски? То есть есть ли что-нибудь, что имеет ментальное состояние понимания или сознательное понимание того, что обсуждается на китайском языке? Мужчина явно не в курсе. Комната не может быть осведомлена. Эти карты , конечно , не знают. Сёрл приходит к выводу, что китайская комната или любая другая система физических символов не может иметь разума.

Сирл продолжает утверждать, что действительные психические состояния и сознание требуют (еще предстоит описать) «фактических физико-химических свойств реального человеческого мозга». Он утверждает, что существуют особые «причинные свойства» мозга и нейронов, которые порождают умы : по его словам, «мозг порождает умы».

Связанные аргументы: мельница Лейбница, телефонная станция Дэвиса, китайская нация Блока и Болван.

Готфрид Лейбниц привел, по сути, тот же аргумент, что и Серл в 1714 году, используя мысленный эксперимент по расширению мозга до размеров мельницы . В 1974 году Лоуренс Дэвис вообразил дублирование мозга с помощью телефонных линий и офисов, укомплектованных людьми, а в 1978 году Нед Блок вообразил, что все население Китая будет вовлечено в такую симуляцию мозга. Этот мысленный эксперимент называется «Китайская нация» или «Китайский спортзал». Нед Блок также предложил свой аргумент «Болванчик» , который представляет собой версию китайской комнаты, в которой программа была преобразована в простой набор правил в форме «смотри это, делай то», удаляя всю загадку из программы.

Отзывы о китайской комнате

Отзывы о китайской комнате подчеркивают несколько разных моментов.

- Системы ответа и виртуальный ум ответ : Этот ответ утверждает , что система , в том числе человека, программы, комнаты, и карты, это то , что понимает китайский. Сирл утверждает, что человек в комнате - единственное, что могло бы «иметь разум» или «понимать», но другие не соглашаются, утверждая, что два разума могут находиться в одном и том же физическом месте, аналогично тому, как это происходит. компьютер может одновременно «быть» двумя машинами: одной физической (например, Macintosh ) и одной « виртуальной » (например, текстовым процессором ).

- Скорость, мощность и сложность ответов : несколько критиков отмечают, что человеку в комнате, вероятно, потребуются миллионы лет, чтобы ответить на простой вопрос, и ему потребуются «картотеки» астрономических размеров. Это ставит под сомнение ясность интуиции Сирла.

- Ответ робота : Некоторые считают, что для того, чтобы по-настоящему понять, китайской комнате нужны глаза и руки. Ханс Моравек пишет: «Если бы мы могли привить робота к программе рассуждений, нам больше не нужен был бы человек, который бы передавал смысл: он пришел бы из физического мира».

- Ответ симулятора мозга : что, если программа имитирует последовательность нервных импульсов в синапсах реального мозга говорящего по-китайски? Мужчина в комнате будет имитировать настоящий мозг. Это вариант «системного ответа», который кажется более правдоподобным, потому что «система» теперь явно работает как человеческий мозг, что усиливает интуицию о том, что помимо человека в комнате есть что-то, что может понимать китайский язык.

- Другие умы ответ и эпифеномены ответ : Некоторые люди отмечают , что аргумент Серело это просто версию проблемы других сознаний , применительно к машинам. Поскольку трудно решить, думают ли люди «на самом деле», не следует удивляться тому, что трудно ответить на тот же вопрос о машинах.

- С этим связан вопрос, существует ли «сознание» (как его понимает Сирл). Сирл утверждает, что переживание сознания нельзя обнаружить, исследуя поведение машины, человека или любого другого животного. Дэниел Деннет указывает, что естественный отбор не может сохранить свойство животного, которое не влияет на его поведение, и, следовательно, сознание (как его понимает Сирл) не может быть произведено естественным отбором. Следовательно, либо естественный отбор не породил сознание, либо «сильный ИИ» верен в том смысле, что сознание может быть обнаружено с помощью соответственно разработанного теста Тьюринга.

Мышление - это своего рода вычисление?

Вычислительная теория разума или « computationalism претензий» , что связь между разумом и мозгом похожа (если не идентична) взаимосвязью между управлением программой и компьютером. Эта идея имеет философские корни у Гоббса (который утверждал, что рассуждение было «не более чем расчетом»), Лейбница (который пытался создать логическое исчисление всех человеческих идей), Юма (который считал, что восприятие можно свести к «атомарным впечатлениям») и даже Кант (который анализировал весь опыт как контролируемый формальными правилами). Последняя версия связана с философами Хилари Патнэм и Джерри Фодором .

Этот вопрос связан с нашими предыдущими вопросами: если человеческий мозг - это разновидность компьютера, то компьютеры могут быть как разумными, так и сознательными, отвечая как на практические, так и на философские вопросы ИИ. Что касается практического вопроса об ИИ («Может ли машина проявлять общий интеллект?»), Некоторые версии вычислительной техники утверждают, что (как писал Гоббс ):

- Рассуждение - это не что иное, как расчет.

Другими словами, наш интеллект происходит от формы вычисления , подобной арифметике . Это гипотеза физической системы символов, обсуждавшаяся выше, и она подразумевает, что искусственный интеллект возможен. Что касается философского вопроса об ИИ («Может ли машина иметь разум, психические состояния и сознание?»), Большинство версий вычислительного подхода утверждают, что (как его характеризует Стеван Харнад ):

- Психические состояния - это просто реализация (правильных) компьютерных программ.

Это «сильный ИИ» Джона Сирла, о котором говорилось выше, и он является реальной целью аргументации китайской комнаты (по словам Харнада ).

Может ли машина вызывать эмоции?

Если « эмоции » определяются только с точки зрения их влияния на поведение или на то, как они функционируют внутри организма, тогда эмоции можно рассматривать как механизм, который интеллектуальный агент использует для максимизации полезности своих действий. Учитывая такое определение эмоции, Ханс Моравец считает, что «роботы в целом будут довольно эмоциональны, если будут хорошими людьми». Страх - это безотлагательный источник. Сочувствие - необходимый компонент хорошего взаимодействия человека с компьютером . Он говорит, что роботы «будут пытаться доставить вам удовольствие, очевидно, самоотверженно, потому что они получат острые ощущения от этого положительного подкрепления. Вы можете интерпретировать это как своего рода любовь». Даниэль Кревье пишет: «Точка зрения Моравека состоит в том, что эмоции - это всего лишь средства для направления поведения в направлении, благоприятном для выживания вида».

Может ли машина осознавать себя?

« Самосознание », как отмечалось выше, иногда используется писателями-фантастами как название важного человеческого свойства, которое делает персонажа полностью человечным. Тьюринг отбрасывает все другие свойства человека и сводит вопрос к следующему: «Может ли машина быть предметом собственного мышления?» Может ли оно думать о себе ? С этой точки зрения можно написать программу, которая может сообщать о своих внутренних состояниях, например отладчик .

Машина может быть оригинальной или креативной?

Тьюринг сводит это к вопросу о том, может ли машина «застать нас врасплох», и утверждает, что это, очевидно, правда, что может подтвердить любой программист. Он отмечает, что при достаточном объеме памяти компьютер может вести себя астрономическим количеством различных способов. Для компьютера, который может представлять идеи, должно быть возможно, даже тривиально, объединить их по-новому. ( Например, « Автоматизированный математик» Дугласа Лената объединил идеи, чтобы открыть новые математические истины.) Каплан и Хенлейн предполагают, что машины могут проявлять научное творчество, в то время как кажется вероятным, что люди будут иметь преимущество в том, что касается художественного творчества.

В 2009 году ученые из Университета Аберистуита в Уэльсе и Кембриджского университета в Великобритании разработали робота по имени Адам, который, по их мнению, станет первой машиной, которая самостоятельно придумала новые научные открытия. Также в 2009 году исследователи из Корнелла разработали Eureqa , компьютерную программу, которая экстраполирует формулы в соответствии с введенными данными, например, нахождение законов движения на основе движения маятника.

Может машина быть доброжелательной или враждебной?

Этот вопрос (как и многие другие в философии искусственного интеллекта) можно представить в двух формах. «Враждебность» может быть определена в терминах функции или поведения , и в этом случае «враждебный» становится синонимом «опасного». Или это можно определить в терминах намерения: может ли машина «сознательно» намереваться причинить вред? Последний вопрос - "может ли машина иметь сознательные состояния?" (например, намерения ) в другой форме.

Вопрос о том, опасны ли высокоинтеллектуальные и полностью автономные машины, подробно исследовали футуристы (например, Исследовательский институт машинного интеллекта ). Очевидный элемент драмы также сделал эту тему популярной в научной фантастике , которая рассматривала множество различных возможных сценариев, в которых интеллектуальные машины представляют угрозу человечеству; см. Искусственный интеллект в художественной литературе .

Одна из проблем заключается в том, что машины могут очень быстро обрести автономию и интеллект, необходимые для того, чтобы быть опасными. Вернор Виндж предположил, что всего за несколько лет компьютеры внезапно станут в тысячи или миллионы раз умнее людей. Он называет это « сингулярностью ». Он предполагает, что это может быть в некоторой степени или, возможно, очень опасно для человека. Это обсуждается философией под названием сингулярность .

В 2009 году ученые и технические эксперты посетили конференцию, на которой обсудили потенциальное влияние роботов и компьютеров и влияние гипотетической возможности того, что они смогут стать самодостаточными и иметь возможность принимать собственные решения. Они обсудили возможность и степень, в которой компьютеры и роботы могут получить любой уровень автономии, и в какой степени они могут использовать такие способности, чтобы, возможно, представлять какую-либо угрозу или опасность. Они отметили, что некоторые машины приобрели различные формы полуавтономности, в том числе возможность самостоятельно находить источники энергии и возможность самостоятельно выбирать цели для атаки с помощью оружия. Они также отметили, что некоторые компьютерные вирусы могут уклоняться от уничтожения и достигли «тараканьего интеллекта». Они отметили, что самосознание, описанное в научной фантастике, вероятно, маловероятно, но есть и другие потенциальные опасности и подводные камни.

Некоторые эксперты и ученые ставят под сомнение использование роботов для ведения боевых действий, особенно когда таким роботам дается некоторая степень автономности. ВМС США профинансировали отчет, в котором указывается, что по мере того, как военные роботы становятся все более сложными, следует уделять больше внимания последствиям их способности принимать автономные решения.

Президент Ассоциации развития искусственного интеллекта заказал исследование, чтобы изучить этот вопрос. Они указывают на такие программы, как Language Acquisition Device, которые могут имитировать человеческое взаимодействие.

Некоторые высказали предположение о необходимости создания « Дружественного ИИ », что означает, что достижения, которые уже происходят с ИИ, должны также включать в себя попытку сделать ИИ по своей сути дружественным и гуманным.

Может ли машина имитировать все человеческие характеристики?

Тьюринг сказал: «Принято ... предлагать немного утешения в форме заявления о том, что машина никогда не сможет воспроизвести какую-то специфически человеческую характеристику ... такие границы могут быть установлены ".

Тьюринг отметил, что существует множество аргументов в форме «машина никогда не сделает X», где X может означать множество вещей, например:

Будьте добры, находчивы, красивы, дружелюбны, проявляйте инициативу, обладайте чувством юмора, отличите правильное от неправильного, совершайте ошибки, влюбляйтесь, наслаждайтесь клубникой и сливками, заставляйте кого-то влюбиться в них, учитесь на опыте, правильно используйте слова , быть предметом собственной мысли, иметь такое же разнообразие поведения, как мужчина, делать что-то действительно новое.

Тьюринг утверждает, что эти возражения часто основаны на наивных предположениях об универсальности машин или являются «замаскированными формами аргументации сознания». Написание программы, демонстрирующей одно из этих поведений, «не произведет большого впечатления». Все эти аргументы касаются основной предпосылки ИИ, если только нельзя показать, что одна из этих черт важна для общего интеллекта.

Может ли у машины быть душа?

Наконец, те, кто верит в существование души, могут возразить, что «мышление - это функция бессмертной души человека» . Алан Тьюринг назвал это «теологическим возражением». Он пишет

Пытаясь сконструировать такие машины, мы не должны непочтительно узурпировать Его силу созидания душ, как и в случае деторождения: скорее, в любом случае мы являемся инструментами Его воли, обеспечивающими обители для душ, которые Он создает.

Взгляды на роль философии

Некоторые ученые утверждают, что игнорирование философии сообществом ИИ пагубно. В Стэнфордской энциклопедии философии некоторые философы утверждают, что роль философии в ИИ недооценивается. Физик Дэвид Дойч утверждает, что без понимания философии или ее концепций разработка ИИ пострадала бы от отсутствия прогресса.

Конференции

Основная серия конференций по этому вопросу - «Философия и теория искусственного интеллекта» (PT-AI), проводимая Винсентом К. Мюллером .

Основная библиография по этой теме с несколькими подразделами находится на PhilPapers .

Смотрите также

- Захват искусственного интеллекта

- Искусственный мозг

- Искусственное сознание

- Искусственный интеллект

- Искусственная нейронная сеть

- Чаттербот

- Китайская комната

- Вычислительная теория разума

- Вычислительная техника и интеллект

- Критика искусственного интеллекта Дрейфусом

- Экзистенциальный риск от продвинутого искусственного интеллекта

- Функционализм

- Многоагентная система

- Философия информатики

- Философия информации

- Философия разума

- Система физических символов

- Смоделированная реальность

- Сверхразум: пути, опасности, стратегии

- Синтетический интеллект

Примечания

использованная литература

использованная литература

- Адам, Элисон (1989). Искусственное знание: гендер и мыслительная машина. Рутледж и CRC Press . https://www.routledge.com/Artificial-Knowing-Gender-and-the-Thinking-Machine/Adam/p/book/9780415129633

- Бенджамин, Руха (2019). Гонка после технологии: инструменты аболиционистов для нового кодекса Джима . Вайли. ISBN 978-1-509-52643-7

- Блэкмор, Сьюзен (2005), Сознание: очень краткое введение , Oxford University Press

- Бостром, Ник (2014), Суперинтеллект: пути, опасности, стратегии , Oxford University Press, ISBN 978-0-19-967811-2

- Брукс, Родни (1990), "Слоны не играют в шахматы" (PDF) , робототехники и автономные системы , 6 (1-2): 3-15, CiteSeerX 10.1.1.588.7539 , DOI : 10.1016 / S0921-8890 ( 05) 80025-9 , извлекаются 2007-08-30

- Брайсон, Джоанна (2019). Искусственный интеллект этики искусственного интеллекта: вводный обзор закона и регулирования, 34.

- Чалмерс, Дэвид Дж (1996), Сознательный разум: в поисках фундаментальной теории , Oxford University Press, Нью-Йорк, ISBN 978-0-19-511789-9

- Коул, Дэвид (осень 2004 г.), «Аргумент о китайской комнате», в Zalta, Эдвард Н. (ред.), Стэнфордская энциклопедия философии.

- Кроуфорд, Кейт (2021). Атлас искусственного интеллекта: власть, политика и планетарные затраты на искусственный интеллект . Издательство Йельского университета.

- Кревье, Даниэль (1993). AI: бурные поиски искусственного интеллекта . Нью-Йорк, штат Нью-Йорк: BasicBooks. ISBN 0-465-02997-3.

- Деннет, Дэниел (1991), Сознание объяснено , Penguin Press, ISBN 978-0-7139-9037-9

- Дрейфус, Хуберт (1972), Что компьютеры не могут сделать , Нью-Йорк: MIT Press, ISBN 978-0-06-011082-6

- Дрейфус, Хуберт (1979), Что компьютеры все еще не могут сделать , Нью-Йорк: MIT Press.

- Дрейфус, Хуберт ; Дрейфус, Стюарт (1986), Разум важнее машины: сила человеческой интуиции и опыта в эпоху компьютеров , Оксфорд, Великобритания: Blackwell

- Фирн, Николас (2007), Последние ответы на самые старые вопросы: философское приключение с величайшими мыслителями мира , Нью-Йорк: Grove Press

- Гладуэлл, Малкольм (2005), Blink: Сила мышления без мышления , Бостон: Little, Brown, ISBN 978-0-316-17232-5.

- Харнад, Стеван (2001), «Что не так и правильно в аргументе Сирла о китайской комнате?», В Bishop, M .; Престон Дж. (Ред.), Очерки аргументации Сирла о китайской комнате , Oxford University Press

- Харауэй, Донна (1985). Манифест киборга .

- Хогеланд, Джон (1985), Искусственный интеллект: сама идея , Кембридж, Массачусетс: MIT Press.

- Хофштадтер, Дуглас (1979), Гедель, Эшер, Бах: вечная золотая коса.

- Хорст, Стивен (2009), «Вычислительная теория разума», в Zalta, Эдвард Н. (редактор), Стэнфордская энциклопедия философии , Лаборатория метафизических исследований, Стэнфордский университет..

- Каплан, Андреас ; Хенлайн, Майкл (2018), «Siri, Siri в моей руке, кто самый справедливый в стране? Об интерпретациях, иллюстрациях и значениях искусственного интеллекта», Business Horizons , 62 : 15–25, doi : 10.1016 / j.bushor .2018.08.004

- Курцвейл, Рэй (2005), Сингулярность близка , Нью-Йорк: Viking Press, ISBN 978-0-670-03384-3.

- Лукас, Джон (1961), «Умы, машины и Гёдель», в Андерсоне, А. Р. (ред.), « Умы и машины».

- Малабу, Екатерина (2019). Морфинг интеллекта: от измерения IQ до искусственного мозга . (К. Шред, Пер.). Издательство Колумбийского университета.

- Маккарти, Джон ; Минский, Марвин ; Рочестер, Натан ; Шеннон, Клод (1955), Предложение для Дартмутского летнего исследовательского проекта по искусственному интеллекту , заархивировано из оригинала 30 сентября 2008 г..

- Макдермотт, Дрю (14 мая 1997 г.), «Насколько интеллектуален Deep Blue» , New York Times , заархивировано из оригинала 4 октября 2007 г. , извлечено 10 октября 2007 г.

- Моравец, Ганс (1988), Дети разума , издательство Гарвардского университета

- Пенроуз, Роджер (1989), Новый разум императора: относительно компьютеров, разума и законов физики , Oxford University Press, ISBN 978-0-14-014534-2

- Рассел, Стюарт Дж .; Норвиг, Питер (2003), Искусственный интеллект: современный подход (2-е изд.), Верхняя Сэдл-Ривер, Нью-Джерси: Prentice Hall, ISBN 0-13-790395-2

- Сирл, Джон (1980), «Умы, мозг и программы» (PDF) , Behavioral and Brain Sciences , 3 (3): 417–457, doi : 10.1017 / S0140525X00005756 , заархивировано из оригинала (PDF) на 2015-09- 23

- Сирл, Джон (1992), Новое открытие разума , Кембридж, Массачусетс: MIT Press

- Сирл, Джон (1999), Разум, язык и общество , Нью-Йорк, Нью-Йорк: Основные книги, ISBN 978-0-465-04521-1, OCLC 231867665

- Тьюринг, Алан (октябрь 1950 г.), «Вычислительные машины и интеллект», Mind , LIX (236): 433–460, DOI : 10.1093 / mind / LIX.236.433 , ISSN 0026-4423

- Йи, Ричард (1993), «Машины Тьюринга и обработка семантических символов: почему настоящие компьютеры не возражают против китайских императоров» (PDF) , Lyceum , 5 (1): 37–59

- Номера страниц выше и содержание диаграмм относятся к распечатке статьи в PDF-формате Lyceum .